電流倍增器:為 AI 處理器及其他嚴苛應用供電的明智之選

AI 處理器需要解决低電壓、高電流的嚴苛挑戰,這將會導致電源系統設計產生瓶頸。瞭解 Vicor 的電流倍增技術如何改變這一現狀

為了提高計算密度並高效應對功耗達 140kW 或更高的機架狀況,超大規模企業現在主張向新一代 AI 超級電腦機架的 ±400VDC 配電發展。

與戰略營銷副總裁 Maury Wood 的問答

在本次獨家問答中,Vicor 認為,資料中心 AI 機架的 ±400VDC 配電是不可避免的。

儘管底層矽晶片的性能有了巨大的飛躍,但人工智慧(AI)訓練仍在推動資料中心電力的突破。斯坦福大學最新的 AI 指數報告顯示,最先進的 AI 模型越來越大,現已達到高達 1 萬億個參數及 15 萬億個 Tokens。

因此,模型訓練需要更多的時間和資源(長達 100 天以及 380 億 petaFLOPS或PFLOPS),而訓練成本會繼續上揚(高達 1.92 億美元)。訓練一個這樣的模型需要多少電力? 超過 2500 萬瓦。

亞馬遜、穀歌、Meta 和微軟等科技巨頭正在轉向核能,以滿足訓練和運行 AI 所需的巨大電力需求。但將大量可靠電力送入其龐大的資料中心只成功了一半。 真正的問題出現在服務器機架本身的內部,其中電力電子產品正在與處理器、記憶體和網路硬體競爭有限的空間。 隨著功率密度的提高,有效管理這種內部配電正在成為一個關鍵問題。

《電子設計》的 James Morra 與 Vicor 戰略市場行銷副總裁 Maury Wood 討論了電力與計算之間的激烈競爭,Maury Wood 認為,解决該問題可能就像將其分開一樣簡單。

首先,系統設計者正在大力提高計算密度,其在 EIA 標準的 19 英寸寬的資料中心服務器機架或 OCP 標準的 21 英寸寬的資料中心服務器機架中,可以採用每昇 petaFLOPS 量測。單個 petaFLOP 相當於每秒 1 千萬億次浮點運算。

一個相關問題是:“為什麼較高的計算密度有助於降低訓練這些大型 AI 模型的運營成本? ”簡而言之,這是因為處理器之間的記憶體頻寬和非最佳時延是效能的瓶頸。大型模型訓練需要大量的低時延記憶體以及無阻塞“全對全”網路架構(在 AI 集群或“超級群組”內支持數十個處理器的共享訪問)。

讓機架中的處理器、記憶體和網路交換機物理距離更近,不僅可新增頻寬,而且還可縮短處理器之間的整體通訊時延,從而可縮短 AI 模型的訓練時間。具體來說,由單個機架定義的較短距離有助於使用無源銅線纜替代有源光收發器,有源光收發器因嵌入的 Retimer 及 DSP,不僅成本更高,而且還非常耗電。

一款典型的 800G QSFP-DD 和 OSFP 收發器的功耗約為 15W。因為這些超級電腦使用數以萬計的光收發器,因此移除所有這些組件節省的電源和成本非常可觀,每個機架可節省高達 20kW 的電力。

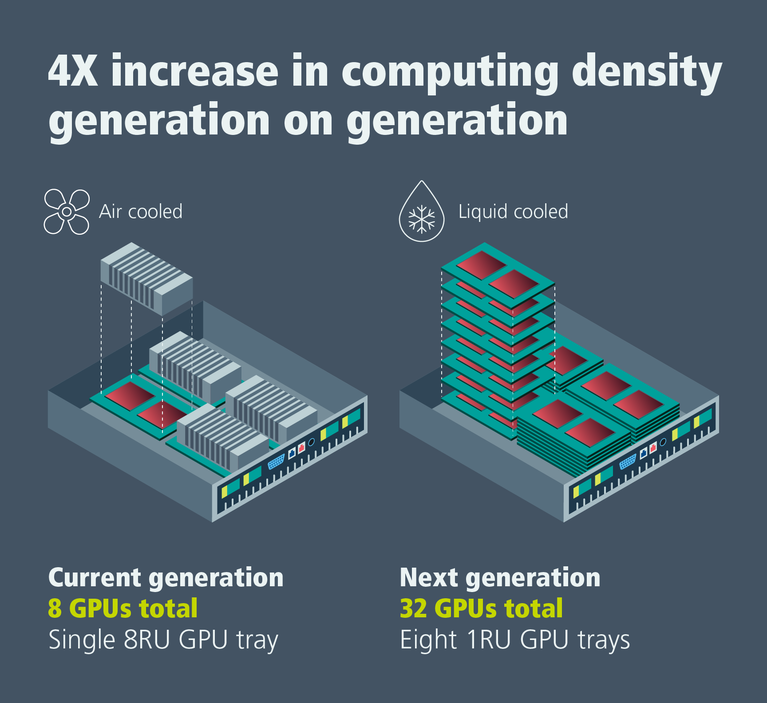

圖 1:從風冷轉向液冷機架級 AI 訓練系統,可實現計算密度的 4 倍增長。

新一代 AI 超級電腦已從風扇強制風冷發展至液冷。 我再問自己一個問題:“這如何助力提高計算密度?”在上一代產品中,有八個處理器的每個託盤配備有十個 80 毫米的風扇和一個大型散熱器,其總共需要八個機架單元(RU)或每個機架單元一個 GPU 的計算密度。

下一代則通過薄水塊冷板採用直接液冷,每個 RU 託盤有兩個 CPU 和四個 GPU。這相當於每個機架單元四個 GPU 的處理器密度,進而提高了 4 倍。

液冷還可消除雜訊並降低這些系統中高速旋轉的 12VDC 風扇所消耗的大量電力。此外,通過保持封裝外殼及矽晶片結點較低的溫度,直接液冷可延長 AI 處理器的平均故障間隔時間。據報導,該時間在風冷 AI 訓練系統中相對較短,會新增停機時間和運營成本。與風冷電腦系統相比,液冷電腦系統通常還能實現更高的時鐘頻率。這兩種結果均可减少 AI 模型的訓練時間和成本。

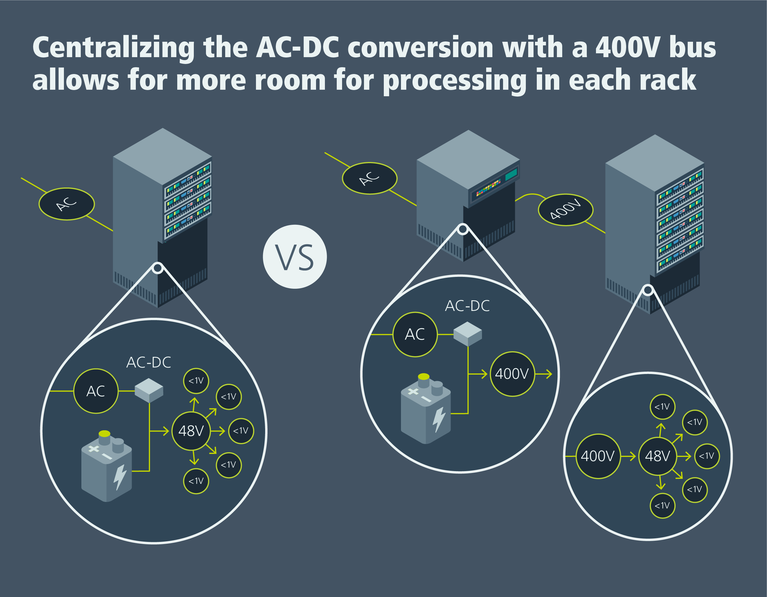

在以往及當代 AI 服務器機架中,採用三相 480VAC(有時為 416VAC)機架配電,會將多達 30% 的機架空間用於 AC-DC 整流、針對 54VDC 的 DC-DC 轉換,以及電池備份單元(BBU)、電容器架和/或不斷電供應系統(UPS)。

為了提高計算密度並高效應對功耗達 140kW 或更高的機架狀況,超大規模企業現在主張向新一代 AI 超級電腦機架的 ±400VDC 配電發展。

圖 2:將 AC-DC 整流和電池備份(BBU)功能從 AI 訓練機架中移除,有助於提高計算密度。

願景是將整流、BBU 和 UPS 功能從 48 個 RU 機架中移除,騰出空間用於增設計算和網絡託盤。假設機架尺寸為:600 毫米寬、1068 毫米深和 2236 毫米高,這可實現 36 個 CPU 和 72 個 GPU 的計算密度,總計每 48 個 RU 約為 720 petaFLOPS。 這種新的系統架構可將每昇訓練效能的計算密度提高到約 0.5 petaFLOPS。

最重要的是,對更低成本、更高 AI 訓練效能的需求將推動計算密度發展,進而促進 ±400VDC 配電的採用。

資料中心現有的 480VAC 配電通常會將 BBU 和 UPS 功能集中起來,提供大型 BBU/UPS 單元,其可通過配電單元(PDU)支持多個 AI/ML 機架。

這些獨立的二合一單元接收交流電,因此它們必須轉換為直流電,才能保持電池充電。此外,BBU/UPS 單元還必須將電池輸出轉換回 AC,而這種雙路轉換過程(先是 AC-DC,然後是 DC-AC)會降低電源利用效率並新增硬體成本。採用 ±400VDC 配電,BBU 和 UPS 無需 AC-DC 整流功能。

400VDC 電壓並非安全超低電壓(SELV)等級,因此會帶來必須處理的安全監管問題。此外,為了保留800VDC 供電的運算選項,必須為每個機架鋪設三根導線(−400V、GND、+400V),這會新增成本。

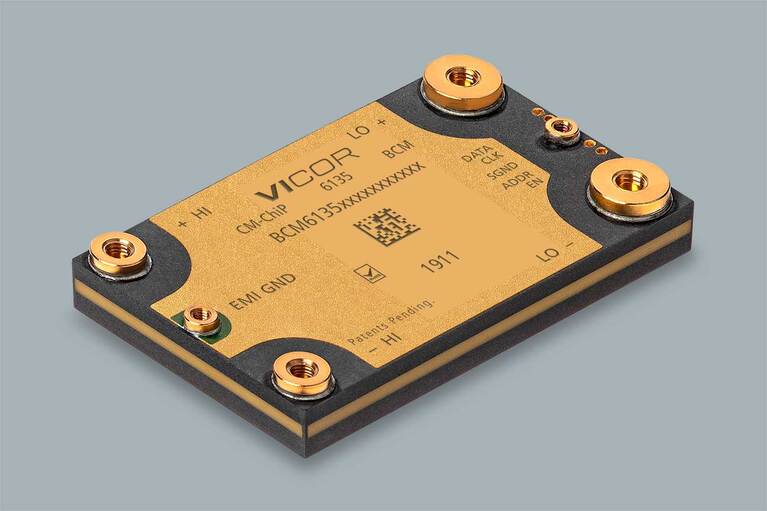

圖 3:Vicor BCM6135 系列電源模組支持 800VDC 及 400VDC 至 54、50 或 48VDC 的高效電壓轉換。

假設每個 AI 機架為 140kW,則這在 400VDC 時為 350A,在 800VDC 時為 175A。高達 350A 的電流可能需要 500MCM 規格的銅線纜(75°C 時,380A 的載流量),而 175A 的電流則可能需要 3/0AWG 的銅線纜(75°C 時,200A 的載流量)。用於 400VDC 配電的 500MCM 規格的銅線纜每英尺成本約為 14 美元,而用於 800VDC 配電的 3/0AWG 銅線纜則每英尺成本約為 5 美元。在大型資料中心,這種幾乎 3 倍的線纜成本差异是很大的。

成本增量有利於 800VDC 配電,但 800V 生態系統沒有 400V 生態系統成熟,因為電動汽車使用 400VDC。然而,汽車製造商正在迅速向 800V 電池及 DC-DC 轉換器過渡,因此成本問題是發展變化的。

最大的挑戰之一是處理機架內的高强度電流。 假設使用 1:8 固定比率 DC-DC 轉換器將 400VDC 標稱電壓轉換為 50VDC 標稱電壓,在 140kW 時,轉換會在 50VDC 下產生 2800A 的電流。這需要一根橫截面約為 1600 平方毫米的鍍銀銅母線,才能滿足風冷母線所需的載流量需求。該橫截面的 2.1 米長母線可能有 5μΩ 的電阻,假設機架功耗持續為 140kW,在 20°C、2800A 下,母線的功耗可能高達 45W。

然而,不僅可使用現有機架內液冷基礎設施對垂直母線進行液冷,而且還可顯著縮小其風冷橫截面,最高可縮小 5 倍(電阻和功耗會隨溫度升高而新增)。這意味著可節省大量的成本和重量。

母線液冷還能更好地控制母線上的最大壓降。這不僅可縮小中間母線轉換器的輸入電壓範圍,而且還可降低 CPU/GPU 加速器計算模組和網路 ASIC 交換模組的負載點穩壓負擔。請注意,在處理數千安培的載流量,以確保最小熱損耗時,選擇 50VDC 連接器也會變得更加重要。

OCP 開放機架 V3 規範和 ORv3 高功率機架(HPR)規範是業界為解决當前及新一代 AI 超級電腦電源及熱工程帶來的工程挑戰而做出的努力。設計新一代AI超級電腦系統仍將涉及導航一系列複雜的工程及經濟權衡。

具有低熱阻與共面表面(可直接與液冷冷板配套)的高密度電源模組將在實現 AI 超級電腦資料中心機架的高壓 DC 配電過程中發揮重要作用。

本文最初由 Electronic Design 發佈。

Maury Wood 現任 Vicor 戰略市場營銷部副總裁。在加入 Vicor 之前,Maury 曾在各種光纖測試與電晶體公司擔任過高級職務,包括 EXFO、AFL、博通、恩智浦、模擬器件以及賽普拉斯等。他畢業於密歇根大學,獲電子工程學士學位,並在美國東北大學、巴布森學院和麻省理工學院完成了研究生學業。Maury 喜歡攀岩、野外滑雪、山地騎行以及爵士貝斯演奏。

Maury Wood,戰略市場營銷部副總裁

電流倍增器:為 AI 處理器及其他嚴苛應用供電的明智之選

AI 處理器需要解决低電壓、高電流的嚴苛挑戰,這將會導致電源系統設計產生瓶頸。瞭解 Vicor 的電流倍增技術如何改變這一現狀

應對資料中心 AI 電源挑戰

隨著 GPU 服務器消耗的電力越來越多,面臨的一大挑戰就是在提升供電能力的同時將損耗、雜訊或停機時間降至最低。瞭解更多詳情

創新供電網路

關於 Vicor 如何創新供電網路領域的白皮書。 提升終端系統性能所需的電源技術

資料中心電力分解

高密度電源模組將在實現人工智慧(AI)超級電腦資料中心架構的高壓直流配電中發揮關鍵作用