电流倍增器:为 AI 处理器及其他严苛应用供电的明智之选

AI 处理器需要解决低电压、高电流的严苛挑战,这将会导致电源系统设计产生瓶颈。了解 Vicor 的电流倍增技术如何改变这一现状

为了提高计算密度并高效应对功耗达 140kW 或更高的机架状况,超大规模企业现在主张向新一代 AI 超级计算机机架的 ±400VDC 配电发展。

与战略营销副总裁 Maury Wood 的问答

在本次独家问答中,Vicor 认为,数据中心 AI 机架的 ±400VDC 配电是不可避免的。

尽管底层硅芯片的性能有了巨大的飞跃,但人工智能 (AI) 训练仍在推动数据中心电力的突破。斯坦福大学最新的 AI 指数报告显示,最先进的 AI 模型越来越大,现已达到高达 1 万亿个参数及 15 万亿个 Tokens。

因此,模型训练需要更多的时间和资源(长达 100 天以及 380 亿 petaFLOPS 或 PFLOPS),而训练成本会继续上扬(高达 1.92 亿美元)。训练一个这样的模型需要多少电力?超过 2500 万瓦。

亚马逊、谷歌、Meta 和微软等科技巨头正在转向核能,以满足训练和运行 AI 所需的巨大电力需求。但将大量可靠电力送入其庞大的数据中心只成功了一半。真正的问题出现在服务器机架本身的内部,其中电力电子产品正在与处理器、存储器和网络硬件竞争有限的空间。随着功率密度的提高,有效管理这种内部配电正在成为一个关键问题。

《电子设计》的 James Morra 与 Vicor 战略市场营销副总裁 Maury Wood 讨论了电力与计算之间的激烈竞争,Maury Wood 认为,解决该问题可能就像将其分开一样简单。

首先,系统设计者正在大力提高计算密度,其在 EIA 标准的 19 英寸宽的数据中心服务器机架或 OCP 标准的 21 英寸宽的数据中心服务器机架中,可以采用每升 petaFLOPS 测量。单个 petaFLOP 相当于每秒 1 千万亿次浮点运算。

一个相关问题是:“为什么较高的计算密度有助于降低训练这些大型 AI 模型的运营成本?”简而言之,这是因为处理器之间的内存带宽和非最佳时延是性能的瓶颈。大型模型训练需要大量的低时延内存以及无阻塞“全对全”网络架构(在 AI 集群或“超级群组”内支持数十个处理器的共享访问)。

让机架中的处理器、内存和网络交换机物理距离更近,不仅可增加带宽,而且还可缩短处理器之间的整体通信时延,从而可缩短 AI 模型的训练时间。具体来说,由单个机架定义的较短距离有助于使用无源铜线缆替代有源光收发器,有源光收发器因嵌入的 Retimer 及 DSP,不仅成本更高,而且还非常耗电。

一款典型的 800G QSFP-DD 和 OSFP 收发器的功耗约为 15W。因为这些超级计算机使用数以万计的光收发器,因此移除所有这些组件节省的电源和成本非常可观,每个机架可节省高达 20kW 的电力。

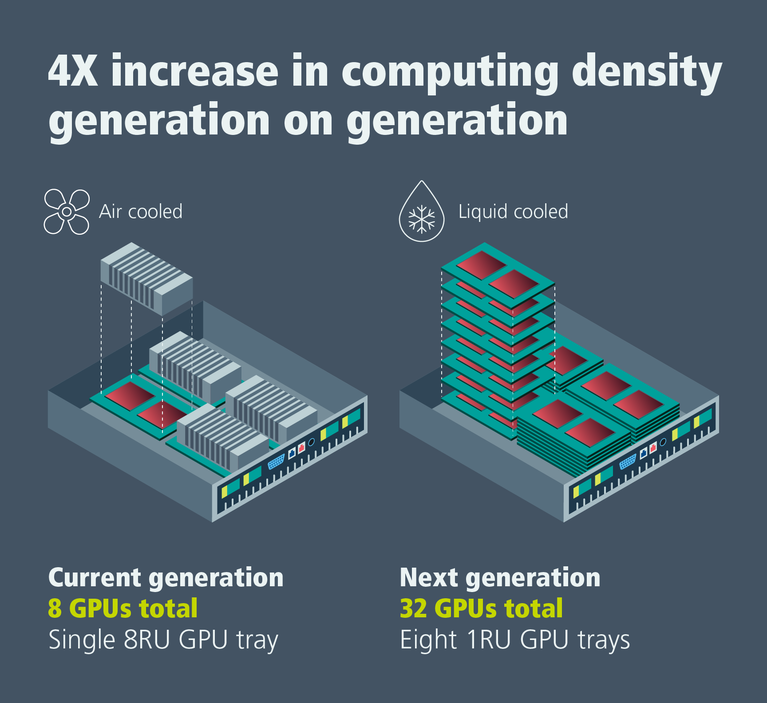

图 1:从风冷转向液冷机架级 AI 训练系统,可实现计算密度的 4 倍增长。

新一代 AI 超级计算机已从风扇强制风冷发展至液冷。我再问自己一个问题:“这如何助力提高计算密度?”在上一代产品中,有八个处理器的每个托盘配备有十个 80 毫米的风扇和一个大型散热器,其总共需要八个机架单元 (RU) 或每个机架单元一个 GPU 的计算密度。

下一代则通过薄水块冷板采用直接液冷,每个 RU 托盘有两个 CPU 和四个 GPU。这相当于每个机架单元四个 GPU 的处理器密度,进而提高了 4 倍。

液冷还可消除噪声并降低这些系统中高速旋转的 12VDC 风扇所消耗的大量电力。此外,通过保持封装外壳及硅芯片结点较低的温度,直接液冷可延长 AI 处理器的平均故障间隔时间。据报道,该时间在风冷 AI 训练系统中相对较短,会增加停机时间和运营成本。与风冷计算机系统相比,液冷计算机系统通常还能实现更高的时钟频率。这两种结果均可减少 AI 模型的训练时间和成本。

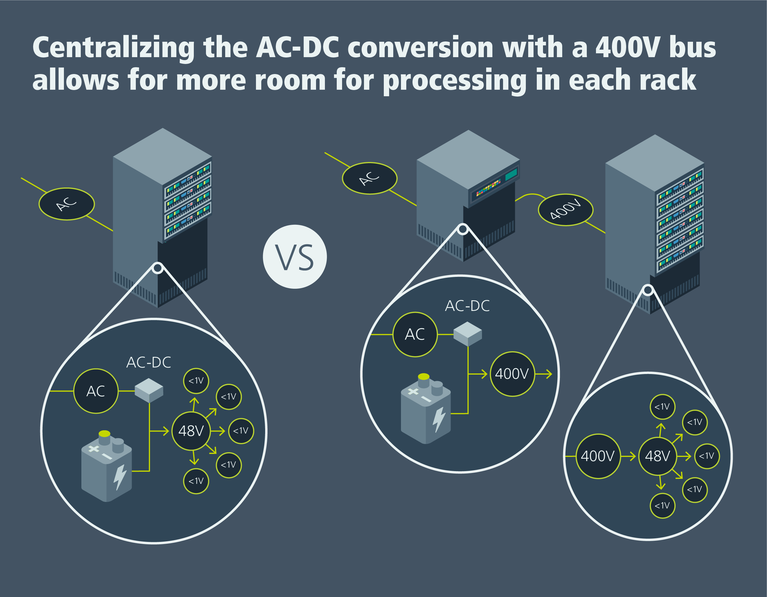

在以往及当代 AI 服务器机架中,采用三相 480VAC(有时为 416VAC)机架配电,会将多达 30% 的机架空间用于 AC-DC 整流、针对 54VDC 的 DC-DC 转换,以及电池备份单元 (BBU)、电容器架和/或不间断电源 (UPS)。

为了提高计算密度并高效应对功耗达 140kW 或更高的机架状况,超大规模企业现在主张向新一代 AI 超级计算机机架的 ±400VDC 配电发展。

图 2:将 AC-DC 整流和电池备份 (BBU) 功能从 AI 训练机架中移除,有助于提高计算密度。

愿景是将整流、BBU 和 UPS 功能从 48 个 RU 机架中移除,腾出空间用于增设计算和网络托盘。假设机架尺寸为:600 毫米宽、1068 毫米深和 2236 毫米高,这可实现 36 个 CPU 和 72 个 GPU 的计算密度,总计每 48 个 RU 约为 720 petaFLOPS。这种新的系统架构可将每升训练性能的计算密度提高到约 0.5 petaFLOPS。

最重要的是,对更低成本、更高 AI 训练性能的需求将推动计算密度发展,进而促进 ±400VDC 配电的采用。

数据中心现有的 480VAC 配电通常会将 BBU 和 UPS 功能集中起来,提供大型 BBU/UPS 单元,其可通过配电单元 (PDU) 支持多个 AI/ML 机架。

这些独立的二合一单元接收交流电,因此它们必须转换为直流电,才能保持电池充电。此外,BBU/UPS 单元还必须将电池输出转换回 AC,而这种双路转换过程(先是 AC-DC,然后是 DC-AC)会降低电源利用效率并增加硬件成本。采用 ±400VDC 配电,BBU 和 UPS 无需 AC-DC 整流功能。

400VDC 电压并非安全超低电压 (SELV) 等级,因此会带来必须处理的安全监管问题。此外,为了保留 800VDC 供电的运算选项,必须为每个机架铺设三根导线(−400V、GND、+400V),这会增加成本。

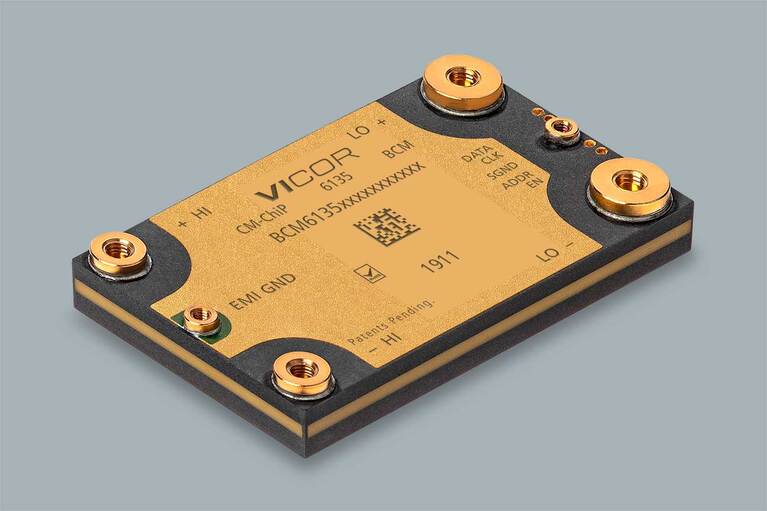

图 3:Vicor BCM6135 系列电源模块支持 800VDC 及 400VDC 至 54、50 或 48VDC 的高效电压转换。

假设每个 AI 机架为 140kW,则这在 400VDC 时为 350A,在 800VDC 时为 175A。高达 350A 的电流可能需要 500MCM 规格的铜线缆(75°C 时,380A 的载流量),而 175A 的电流则可能需要 3/0AWG 的铜线缆(75°C 时,200A 的载流量)。用于 400VDC 配电的 500MCM 规格的铜线缆每英尺成本约为 14 美元,而用于 800VDC 配电的 3/0AWG 铜线缆则每英尺成本约为 5 美元。在大型数据中心,这种几乎 3 倍的线缆成本差异是很大的。

成本增量有利于 800VDC 配电,但 800V 生态系统没有 400V 生态系统成熟,因为电动汽车使用 400VDC。然而,汽车制造商正在迅速向 800V 电池及 DC-DC 转换器过渡,因此成本问题是发展变化的。

最大的挑战之一是处理机架内的高强度电流。假设使用 1:8 固定比率 DC-DC 转换器将 400VDC 标称电压转换为 50VDC 标称电压,在 140kW 时,转换会在 50VDC 下产生 2,800A 的电流。这需要一根横截面约为 1600 平方毫米的镀银铜母线,才能满足风冷母线所需的载流量需求。该横截面的 2.1 米长母线可能有 5μΩ 的电阻,假设机架功耗持续为 140kW,在 20°C、2,800A 下,母线的功耗可能高达 45W。

然而,不仅可使用现有机架内液冷基础设施对垂直母线进行液冷,而且还可显著缩小其风冷横截面,最高可缩小 5 倍(电阻和功耗会随温度升高而增加)。这意味着可节省大量的成本和重量。

母线液冷还能更好地控制母线上的最大压降。这不仅可缩小中间母线转换器的输入电压范围,而且还可降低 CPU/GPU 加速器计算模块和网络 ASIC 交换模块的负载点稳压负担。请注意,在处理数千安培的载流量,以确保最小热损耗时,选择 50VDC 连接器也会变得更加重要。

OCP 开放机架 V3 规范和 ORv3 高功率机架 (HPR) 规范是业界为解决当前及新一代 AI 超级计算机电源及热工程带来的工程挑战而做出的努力。设计新一代 AI 超级计算机系统仍将涉及导航一系列复杂的工程及经济权衡。

具有低热阻与共面表面(可直接与液冷冷板配套)的高密度电源模块将在实现 AI 超级计算机数据中心机架的高压 DC 配电过程中发挥重要作用。

本文最初由 Electronic Design 发布。

Maury Wood 现任 Vicor 战略市场营销部副总裁。在加入 Vicor 之前,Maury 曾在各种光纤测试与半导体公司担任过高级职务,包括 EXFO、AFL、博通、恩智浦、模拟器件以及赛普拉斯等。他毕业于密歇根大学,获电子工程学士学位,并在美国东北大学、巴布森学院和麻省理工学院完成了研究生学业。Maury 喜欢攀岩、野外滑雪、山地骑行以及爵士贝斯演奏。

Maury Wood,战略市场营销部副总裁

电流倍增器:为 AI 处理器及其他严苛应用供电的明智之选

AI 处理器需要解决低电压、高电流的严苛挑战,这将会导致电源系统设计产生瓶颈。了解 Vicor 的电流倍增技术如何改变这一现状

应对数据中心 AI 电源挑战

随着 GPU 服务器消耗的电力越来越多,面临的一大挑战就是在提升供电能力的同时将损耗、噪声或停机时间降至最低。了解更多详情

创新供电网络

关于 Vicor 如何创新供电网络领域的白皮书。提升终端系统性能所需的电源技术

数据中心电力分解

高密度电源模块将在实现人工智能(AI)超级计算机数据中心架构的高压直流配电中发挥关键作用